在现代应用软件开发中,异步处理是提升系统性能、解耦服务组件和保证用户体验的关键技术。结合 Go 语言的并发优势、Kafka 的高吞吐消息队列能力和 MongoDB 的灵活文档存储,我们可以构建一个高效、可扩展的异步处理系统。本文将详细介绍如何利用这三个技术栈构建一个典型的异步处理应用。

1. 系统架构概述

一个典型的基于 Kafka 和 MongoDB 的 Go 异步处理系统通常遵循生产者-消费者模式:

- 生产者 (Producer): 负责将需要异步处理的任务(如用户注册邮件发送、图片处理、数据同步等)封装为消息,并发布到 Kafka 指定的主题(Topic)中。

- Kafka 集群: 作为系统的消息中枢,负责高可靠、高吞吐地缓冲和传递这些消息。它可以对消息进行持久化,并支持多个消费者组并行消费。

- 消费者 (Consumer): 由一个或多个 Go 协程实现的消费者程序,订阅 Kafka 主题,持续拉取消息,并执行业务逻辑处理。

- MongoDB: 作为处理结果的持久化存储,或者作为任务处理过程中的状态和中间数据的存储。其无模式的文档模型非常适合存储异步任务的各种状态和结果。

2. 技术选型与优势

- Go (Golang): 其原生的 Goroutine 和 Channel 机制,为编写高并发的消费者程序提供了极大的便利,能以极低的资源开销处理大量并发任务。

- Apache Kafka: 一个分布式流处理平台,具有高吞吐、低延迟、持久化、可水平扩展和容错性强等特点,是构建异步处理管道的事实标准。

- MongoDB: 一个基于文档的 NoSQL 数据库,其灵活的 BSON 格式可以轻松存储任务的各种复杂参数和结果,且易于扩展。

3. 核心实现步骤

a. 环境搭建与依赖引入

确保已部署 Kafka 集群和 MongoDB 服务。在 Go 项目中,引入核心库:

import (

"gopkg.in/confluentinc/confluent-kafka-go.v1/kafka" // Kafka Go 客户端

"go.mongodb.org/mongo-driver/mongo" // MongoDB 官方驱动

"go.mongodb.org/mongo-driver/mongo/options"

)b. 生产者端实现

生产者负责创建任务消息。例如,用户上传一个视频后,生产者生成一个“视频转码”任务。

`go

func produceTask(taskID string, taskData map[string]interface{}) error {

p, err := kafka.NewProducer(&kafka.ConfigMap{"bootstrap.servers": "localhost:9092"})

if err != nil { return err }

defer p.Close()

// 将任务数据序列化(如 JSON)

value, _ := json.Marshal(taskData)

topic := "async-tasks"

// 发送消息到 Kafka

err = p.Produce(&kafka.Message{

TopicPartition: kafka.TopicPartition{Topic: &topic, Partition: kafka.PartitionAny},

Value: value,

Key: []byte(taskID), // 可使用任务ID作为Key保证顺序

}, nil)

return err

}`

可以在 MongoDB 中插入一条任务记录,初始状态为 PENDING。

c. 消费者端实现

消费者以协程(或工作池)方式运行,持续消费并处理任务。

`go

func startConsumerGroup() {

c, err := kafka.NewConsumer(&kafka.ConfigMap{

"bootstrap.servers": "localhost:9092",

"group.id": "video-processing-group",

"auto.offset.reset": "earliest",

})

if err != nil { log.Fatal(err) }

defer c.Close()

c.SubscribeTopics([]string{"async-tasks"}, nil)

for {

msg, err := c.ReadMessage(-1)

if err == nil {

// 启动一个 Goroutine 处理消息,实现并发消费

go processTask(msg.Value)

} else {

log.Printf("Consumer error: %v (\n)", err)

}

}

}

func processTask(message []byte) {

var taskData map[string]interface{}

json.Unmarshal(message, &taskData)

taskID := taskData["id"].(string)

// 1. 更新 MongoDB 中任务状态为 PROCESSING

updateTaskStatus(taskID, "PROCESSING")

// 2. 执行业务逻辑(如视频转码、发送邮件等)

err := doBusinessLogic(taskData)

// 3. 根据处理结果,更新 MongoDB 中的任务状态和结果

if err != nil {

updateTaskStatus(taskID, "FAILED")

logTaskError(taskID, err)

} else {

updateTaskStatus(taskID, "COMPLETED")

saveTaskResult(taskID, resultData)

}

}`

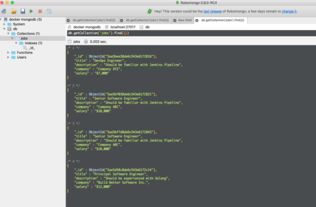

d. MongoDB 交互

定义与 MongoDB 交互的辅助函数,用于更新任务状态和存储结果。

func updateTaskStatus(taskID, status string) {

collection := mongoClient.Database("asyncDB").Collection("tasks")

filter := bson.M{"_id": taskID}

update := bson.M{"$set": bson.M{"status": status, "updatedAt": time.Now()}}

collection.UpdateOne(context.Background(), filter, update)

}4. 高级考量与优化

- 错误处理与重试: 在

processTask中加入重试逻辑,对于可重试的错误(如网络抖动),可以将消息重新发布到一个“重试主题”或延迟队列。 - 消息幂等性: 确保同一消息被消费多次不会导致重复的业务结果,可通过 MongoDB 记录已处理消息的 ID 来实现。

- 消费者伸缩: 通过调整 Kafka 分区数量和 Go 消费者协程的数量,可以轻松实现水平扩展,提升处理能力。

- 监控与观测: 集成监控工具,跟踪 Kafka 的 Lag(积压),监控 Go 程序的 Goroutine 数量和 MongoDB 的性能指标。

- 事务支持(可选): 对于严格要求“消息消费”与“数据库更新”一致性的场景,可以探索 Kafka 事务或使用“两阶段提交”模式,但在异步系统中通常追求最终一致性。

5. 应用场景

此架构非常适合以下场景:

- 用户行为事件追踪与分析

- 通知系统(邮件、短信、推送)

- 图片、音视频的异步处理与转码

- 订单后续处理流程(如库存扣减、积分增加、日志记录)

- 数据同步与ETL流程

结论

结合 Go、Kafka 和 MongoDB 构建的异步处理系统,充分发挥了 Go 的并发性能、Kafka 的可靠消息传递和 MongoDB 的灵活数据存储能力。这种架构不仅能够有效应对流量高峰,将耗时操作与主请求路径解耦以提升响应速度,还通过组件的水平扩展性为系统的长期演进奠定了坚实基础。在实现时,开发者需要根据具体业务需求,妥善设计消息格式、错误处理策略和一致性模型,从而构建出既稳健又高效的后端服务。